Musikproduktion am Computer

[Disclaimer: als Steinberg-Mitarbeiter (näheres steht in der „About“-Sektion) bin ich natürlich Partei. Meine an Cubase orientierte Darstellung kommt aber nicht zustande, weil ich meinem Arbeitgeber einen Gefallen tun will - sie verdankt sich dem Umstand, daß ich seit 1990 an dieser Software arbeite und stets genug Möglichkeiten der Mitsprache hatte, um mich mit ihr sehr weitgehend zu identifizieren.]

Audio vs. MIDI

Musik kann man im Computer in zwei grundsätzlich unterschiedlichen Welten aufnehmen und bearbeiten: Audio und MIDI.

Das Audioformat entspricht dem, was auch auf einer CD landet: das ist die direkte digitale Kodierung von akustischen Signalen. Dabei wird - um es einfach zu sagen - das akustische Spektrum mit einer bestimmten Frequenz abgetastet und als Abfolge von „akustischen Fotos” auf die Festplatte geschrieben. Solche „Fotos” nennt man Samples, und die Frequenz, in der sie zu einem „Film” kombiniert werden, Samplerate. Auf einer Audio-CD finden sich zwei (Stereo-)Spuren aus 16-Bit-Samples mit einer Samplerate von 44.1kHz.[1]

MIDI („Music Instrument Digital Interface”) hingegen ist ein Datenformat, das lediglich Kontrollinformationen enthält, mit denen sich ein Klangerzeuger steuern läßt - die musikalischen Parameter sind hier getrennt von ihrem konkreten Klang. Man kann z.B. darüber bestimmen, daß eine „Note” mit einer bestimmten Tonhöhe und -lautstärke „eingeschaltet” wird, auch ohne sich dabei auf einen bestimmten Klang - Klavier oder Orchester, Drumset oder Handclap - festzulegen. Ein MIDI-Keyboard produziert einen ständigen Strom solcher „Note-On” und „Note-Off”-Befehle, der an ein anderes Gerät weitergeleitet werden kann - anhand des MIDI-Protokolls läßt sich ein Netzwerk von Geräten befeuern, die voneinander nichts wissen.

Die Audio-Welt ist zunächst eher starr und unflexibel, weil sämtliche Parameter in einem einzigen Datenstrom miteinander vermengt sind; dafür ist es möglich, eine „echte” Performance komplett in den Computer zu ziehen - eine vom Virtuosen gespielte Gitarre etwa, oder echten Gesang. Die MIDI-Welt hingegen ist unendlich flexibel, weil die musikalischen Parameter in isolierter Form vorliegen und sowohl in ihrer Qualität (laut/leise, hoch/tief) als auch in ihrer zeitlichen Ordnung beliebig manipulierbar sind. Dafür ist man auf Klangerzeuger verwiesen, die letztlich immer Computer sind, mit all den Vorteilen beliebiger Manipulierbarkeit - und dem großen Manko, über keinerlei Intelligenz zu verfügen.

- [1] Es gibt aber auch andere Formate, die Samples mit mehr Informationen (24- oder 32-Bits) in einer höheren Frequenz (96.2kHz) aufzeichnen. - MP3 und andere komprimierte Formate spielen nur für das Endresultat eine Rolle, und kommen bei Aufnahme und Bearbeitung nicht vor.

Angefangs war Musiksoftware fast ein Synonym für den reinen MIDI-Sequenzer. Irgendwann gab es die erste Audiospur – immerhin schon ganz zu Beginn in Stereo, – die freilich nur mit teurer Hardware (Karten mit DSP-Chips) realisierbar war. Heute sind auch weit mehr als 100 Audiospuren kein Problem mehr, und deren Processing bewältigt die CPU des Heim-PC.

Mittlerweile verschwimmen auch die Grenzen zwischen Audio und MIDI mehr und mehr. Am Anfang stand die Einführung von Samplern, Geräten also, die immer noch über MIDI gesteuert werden, aber ihren Sound generieren, indem sie Audioaufnahmen wiedergeben. Dabei stand zunächst längst nicht genug Speicherplatz und Bandbreite zur Verfügung, um etwa einen mehrminütigen Streichersound komplett im Speicher zu halten, und diesen dann auch noch für jeden einzelnen Ton über mehrere Oktaven – von den Limitierungen des Bussystems zu schweigen, womöglich noch mehrstimmige Akkorde an die Hardware zu schicken. Statt dessen wurde nur ein kurzer Schnipsel (eben ein „Sample”, ein „Beispiel”) aufgenommen, dessen Einschwingphase (das Attack, das für die Charakteristik akustischer Instrumente eine große Rolle spielt) beibehalten wurde, den man dann aber durch eine ständige Wiederholung in der Haltephase (einem Loop des Sustain) künstlich verlängerte. Außerdem wurde nicht jeder einzelne Ton "gesampelt", sondern nur z.B. drei Töne in einer Oktave; die übrigen Töne wurden dann durch Interpolation, durch „Pitchshift” künstlich generiert.

Mittlerweile sind Speicher und Bandbreite drastisch im Preis gefallen, und heutige Sample-Libraries enthalten über größere Zeiträume und mit jedem Halbton gesampeltes Material. Zudem brauchen sie längst keine spezialisierte Hardware mehr, sondern werden von Software abgespielt, die auf der Haupt-CPU läuft. In jenen frühen Tagen liegt jedoch der Anfang für eine Technik, die auch heute eine große Rolle spielt: Timestrech und Pitchshift.

Wenn man eine Aufnahme vom Tonband schneller laufen läßt, klingt sie gleichzeitig höher. Für digitales Audio gilt dies ebenso – was für einen Sampler höchst unerwünschtes Verhalten ist. Wenn man einen gesampelten Naturklang schneller abspielt, verliert er seinen Charakter und klingt sehr rasch unnatürlich („Mickey-Maus”–Effekt). Jene frühen Sampler aus den neunziger Jahren mußten Verfahren entwickeln, die wenigen Samples, die in ihre Speicher paßten, so zu „pitchen”, daß sie ihren Charakter nicht allzu drastisch einbüßen. Das war der Anfang einer Technologie, die heute mächtig genug ist, um in einer Liveaufnahme einzelne Töne zu verändern – selbst in den Pitchverlauf innerhalb eines einzelnen Tons läßt sich mittlerweile eingreifen (um z.B. unsauber intonierten Gesang zu begradigen).

Es gibt dabei eine Reihe von Auswirkungen auf die Ästhetik der heutigen Popmusik (die zu 99% im Computer produziert wird). Interessanterweise liegen die nicht nur in den objektiven Möglichkeiten, die selbst ein Studio im heimischen Wohnzimmer mittlerweile bietet, sondern auch in der Historie der Entwicklung jener Features.

Komposition vs. Abmischen

Mit dem Begriff „Musikproduktion” fasse ich zwei Gebiete zusammen, die zwar eng miteinander zusammenhängen und in der Praxis idR ineinander übergehen, die aber dennoch eine ganz verschiedene Herangehensweise an das Material darstellen, und auch recht unterschiedliche Werkzeuge erfordern. Ich meine die Komposition auf der einen, und das Abmischen auf der anderen Seite.

Komponieren kann man auch am Klavier, oder sogar nur mit Bleistift und Notenpapier. Der Computer kann hier helfen, indem er die Einfälle sofort hör- und damit kontrollierbar macht – und zwar auch solche, die man selber gar nicht spielen kann. Außerdem läßt sich mit allen Ebenen des musikalischen Materials im besten Sinn des Wortes spielerisch umgehen: man kann einen Ton mit einem Mausklick in der Tonhöhe und der Lautstärke, aber auch im zeitlichen Verlauf oder in der Klangfarbe verändern. Auch auf der übergeordneten formalen Ebene kann man leicht Experimente anstellen, indem man die Abfolge ganzer formaler Blöcke mit wenigen Mausklicks verändert. Ein Bigband-Arrangement oder eine ganze Orchesterpartitur läßt sich unter ständiger visueller und akustischer Kontrolle zusammenbauen, ohne daß der Komponist sich das mit seinem inneren Ohr lediglich vorstellen muß.

Dem gegenüber steht die Aufgabe, am Computer eine gegebene Komposition zum Klingen zu bringen, d.h., aus Rohmaterial eine Audiodatei zu generieren, die man für den Endgebrauch auf eine CD brennen kann. Hier geht es nicht darum, einzelne Töne, Akkordfortschreitungen oder formale Blöcke zu editieren; es geht um die Ebene des Klanges in all seiner Komplexität. Ein Schlagzeug-Set etwa braucht überzeugende Sounds für Bassdrum, Snare und Becken, wenn man es mit einem Drumcomputer zu tun hat. Selbst ein live eingespieltes Set wird mit einer ganzen Anzahl von Mikrophonen aufgenommen, die eine ebenso große Anzahl von Audiospuren ergeben, die klanglich nachgearbeitet und gegeneinander abgemischt werden müssen. Nicht zuletzt geht es darum, die einzelnen Schlaginstrumente im Raum anzuordnen, und zwar einmal im Stereo-Panorama, und zum anderen in der räumlichen Staffelung von "vorne" und "hinten" – von einem Surround-Mix ganz zu schweigen.

Diese beiden Aufgaben überlappen sich in der Praxis natürlich. Wenn man vor einem Drumcomputer sitzt, werden sich die Erfindung der Grooves und die Auswahl der Sounds einander bedingen, und bei der Arbeit an einer Orchesterpartitur wird man seine Sample-Library so auf dem Mischpult organisieren, daß die ersten Geigen links, und die Celli rechts zu hören sind. Viele Stücke leben von ihrem Klang, und dort wird der Sound gleichzeitig mit den harmonischen oder formalen Strukturen entwickelt. Aber auch ein Komponist "klassischer" Musik mag zu einem Punkt kommen, wo ihn der Klang der Instrumente des virtuellen Orchesters in seinem Studio zu neuen Ideen inspiriert.

Sequencer

Die zentrale Software, die man bedienen muß, wenn man am Computer Musik machen will, ist der Sequencer (ich bleibe bei dem Namen, auch wenn die versammelte Macht des Marketings es durchgesetzt hat, daß man mittlerweile von einer „Digitalen Audio Workstation”, oder DAW, redet). Der Begriff hat seine Wurzeln noch in der Hardware der 70er Jahre, als erstmals analoge Sequencer und (die mit ihnen eng verwandten) Drummachines die Bühne betraten - Geräte, mit denen man Abfolgen von (wenigen) Tönen festlegen konnte, die sich hinterher zu einer Folge von solchen Sequenzen (aka Pattern) kombinieren ließen.

Die ersten Software-Sequencer sind diesem Konzept gefolgt (wie übrigens generell in der Musikindustrie Konzepte zuerst in Hardware zur Verfügung standen, um erst später als Software auf den immer leistungsfähigeren Home-PCs zu laufen): man hat dort mit einer vorher festzulegenden Zahl von Takten („Pattern”) zu tun, die sich hinterher zu einem „Song” zusammenfügen lassen [1].

Ende der Achtziger erschien mit „Cubase” ein Software-Sequencer, der rasch zum Standard für alle anderen Programme auf diesem Gebiet wurde: die Benutzeroberfläche zeigt ein virtuelles Tonbandgerät, wobei auf der vertikalen Achse dessen Spuren, und auf der horizontalen das Tonband in seinem zeitlichen Verlauf dargestellt wird. Man kann sich das auch so vorstellen, daß man ganz links eine Liste der unterschiedlichen Instrumente sieht, und daneben die von diesen gespielten Noten in ihrem zeitlichen Verlauf.

Die einzelnen Spuren des virtuellen Tonbands sind weit variabler editierbar als jene auf der Hardware: man kann nicht nur das komplette Band in Stücke zerscheiden, die man hinterher in einer neuen Reihenfolge wieder zusammenkleben kann, sondern man kann auch innerhalb der einzelnen Spuren manipulieren: man arbeitet mit Parts, mit Schnipseln beliebiger Größe, die man beliebig positionieren, kopieren, schneiden, und löschen kann.

(Screenshot: Cubase/Atari aus den frühen Neunzigern.)

- [1] Ein ganz heißer Tip, wenn man die frühen Sequencer in Aktion hören will - und nicht nur dafür: das ist zeitlos gültige Musik - sind die Soloalben von John Surman - z.B. dieses Werk.

Sampler

Sampler gehören zu einer spezielle Gattung von elektronischen Musikinstrumenten, die irgendwo zwischen Synthesizer und Tonbandgerät angesiedelt ist. Das sind MIDI-Geräte, die von Kontrollinformationen gesteuert werden - dabei generieren sie ihre Sounds jedoch nur teilweise elektronisch, und geben in erster Linie digitale Audioaufnahmen wieder.

Ein „Sample” ist ein Schnipsel Audio - die digitale Aufnahme z.B. von zwei Sekunden vom Alt-Saxophon auf dem zweigestrichenem „Es” in einer bestimmten Lautstärke. Ein Sampler-„Sound” (ein vom MIDI-Keyboard spielbares Altsaxophon etwa) ist zusammengesetzt aus einer ganzen Anzahl von Samples - einer Sammlung aus in verschiedenen Tonhöhen und Lautstärken gespielten Tönen jenes Saxophons. Auf diese Aufnahmen greift die Elektronik zurück, wenn sie ein MIDI-Kommando erhält - wenn ein Ton in einer verlangten Tonhöhe als Audiodatei vorliegt, wird diese direkt abgespielt, andernfalls wird ein möglichst dicht daneben liegender Ton gesucht und „gepitcht”[1]. Ähnliches gilt für Lautstärke und - ganz prominent - Tondauer: wenn ein Sample bis zum Ende abgespielt wurde, der Ton aber immer noch weiterklingen soll, spielt der Sampler eine Endlosschleife zwischen zwei vorher vom Sounddesigner festgelegten „Loop”-Punkten.

Diese beiden Eingriffe - Pitchshift und Looping - allein sind schon kritisch genug, um Sounds aus dem Sampler eine hörbare „Künstlichkeit” zu verleihen. Dabei sind allerdings heute verfügbaren Pitchshift-Algorithmen ausgefeilt genug, um es zu erlauben, selbst eine komplette Gesangsaufnahme in einem gewissen Rahmen zu transponieren, ohne daß dies groß auffällt (von mikrotonalen Eingriffen ganz zu schweigen, mit denen man z.B. Ungenauigkeiten in der Intonation glattbügeln kann) - zudem stellen Speicherplatz und Busgeschwindigkeit heute kein (größeres) Problem mehr dar, so daß man Samples auf jedem Halbton, in zahlreichen „Velocity Layers” und ausgiebiger Länge benutzen kann, und trotzdem noch Luft genug hat, vier oder acht oder noch mehr Töne gleichzeitig zu spielen.

Bei guten Sample-Libraries hat man es letztlich mit (technisch hervorragenden) Aufnahmen von Naturinstrumenten zu tun, die man hinterher Ton für Ton beliebig miteinander verknüpfen kann. Man würde erwarten, daß man keine Probleme hat, mit diesen Mitteln mein Beispiel - das Altsaxophon - auf einem MIDI-Keyboard zu spielen, oder es zumindest im Nachhinein auf dem Computer so nachzustellen, daß es vom Original ununterscheidbar wäre. Das ist aber nur in einem sehr eingeschränkten Maße möglich - und zwar selbst für jemanden, der das Instrument bis ins Detail kennt, und auch sämtliche Möglichkeiten der Computertechnik auszuschöpfen versteht. Diesen - sehr seltenen - Typus Musikers gibt es tatsächlich, und der löst das Problem auf die einzige wirklich befriedigende Weise: er holt sich einen guten Saxophonisten ins Studio.

- [1] Glossar:

Sample = Audioaufnahme (idR kurz und monophon)

Pitch = Tonhöhe - -shift = dessen Manipulation

Velocity = Lautstärke bzw. Anschlagsgeschwindigkeit

Drumcomputer

Eine der ersten Aufgaben des Computers – nachdem er, als „PC”, einigermaßen Verbreitung gefunden hatte – war die Auflösung eines einst hochgeachteten Berufsstandes: jenes der (Studio-)Drummer. Frühe Musikprogramme konnten ziemlich gar nichts, außer Geräusche zu machen – dies jedoch in überaus akkuratem Timing. Das allein genügte, um geplagte Studiobetreiber und Produzenten dazu zu bewegen, auf den stundenlangen Aufwand zu verzichten, ein Drumset im Studio aufzubauen und vernünftig zu mikrophonieren – nur um danach den Drummer darum anzubetteln, doch bitte nichts selber zu erfinden, sondern genau den Schwachsinn zu spielen, den man sich – als Nicht-Dummer – ausgedacht hatte.

Es ist gut möglich, daß sich die Geschichte der Popmusik seit den achtziger Jahre in einem Essay über die

Heute ist man etwas weiter: statt sich mit den künstlichen Sounds der analogen Drummachines zu begnügen, kann man auf Samples von akustischen Instrumenten zurückgreifen – und zwar auf mehreren Ebenen. Zum einen verbergen sich hinter den Tasten heutiger Drummachines (und ihrer virtuellen Nachfolger als Software) idR gesampelte Originalinstrumente - und zwar in einer beeindruckenden Qualität. Zum zweiten kann man auf ganze Bibliotheken von „Drumloops” zurückgreifen, in denen man zwei oder vier Takte von kompletten – häufig live aufgenommenen – Schlagzeug-Grooves findet. Nicht zuletzt ist es heute möglich, solche „Loops” in einzelne „Slices” zu zerlegen, über die sich hinterher frei verfügen läßt - sei es, daß man nur das Tempo des kompletten Loops ändern will, sei es, daß man dessen Bestandteile völlig neu zusammensetzen möchte.

Nachtrag: In meinem Essay über Technologische Neuerungen gibt es einen Exkurs, der die Entwicklung der Drummachines thematisiert.

- [1] Immer 120 Schläge pro Minute - es handelte sich stets um stilistische Revolutionen, wenn man das Tempo veränderte, was schon daran deutlich wird, daß man für "Tempo" ein neues Wort erfand: BPM, Beats per Minute.

Analog vs. Digital

Eine erste Konsequenz beim Einsatz von Drumcomputern war das Verschwinden der Cymbals (= Becken) im Schlagzeugsound. Dafür war anfangs der limitierte Speicherplatz früher Sampler verantwortlich, der es nicht erlaubte, ein lange ausklingendes Ride- oder Crash-Cymbal aufzunehmen. Im Gegensatz zu vielen anderen akustische Instrumenten sind für diese Sounds nämlich nicht nur der kurze Moment des Anschlags oder Einklingens charakteristisch, sondern der komplette Verlauf im Klang - das macht es vergleichsweise einfach, eine Flöte zu sampeln (die durch ihr typisches Anblasgeräusch sofort erkennbar ist), und fast unmöglich, einen lange gehaltenen Ton nachzustellen, der von einem Saxophon (für den unendlich viele Modulationen in Klangfarbe und Lautstärke typisch sind) oder eben einem Becken stammt. - Das hat man schon immer so gewußt, und deshalb lange Jahre bestimmte Instrumente entweder live hinzu genommen, oder - in einem Akt der Selbstbeschränkung - auf ihren Einsatz verzichtet. In den Computerbeats der Achtziger gibt es die kurze HiHat, nicht aber die Klangwolken der Cymbals.

Limitierungen des Speicherplatzes spielen heute keine Rolle mehr - im Zweifelsfall kann man ein Sample von der Dauer einer halben oder einer ganzen Minute verwenden. Dennoch läßt sich ein prinzipielles Problem nicht lösen: die Reduktion der Komplexität, die für alles Digitale zwingend erforderlich ist, und an der die Simulation eines einfachen Vorgangs wie das wiederholte Schlagen auf ein Becken letztlich scheitert.

- Zunächst gibt es im analogen Raum eine unendliche Vielzahl von Lautstärken, die sich realisieren lassen. Wenn man eine Schlagzeug-Performance mit äußerst feinen Meßinstrumenten aufzeichnen würde, wäre nicht ein einziger Schlag exakt ebenso laut wie irgend ein anderer. - Im Fall von MIDI gibt es einen Wertebereich von 0-127 für den „Velocity”-Parameter, ein vergleichsweise grobes Raster, das aber selbst heute völlig ausreichend ist, weil ein noch viel gröberes Raster im Sampler seine Anwendung findet: die Velocity-„Layer”. Jede Veränderung in der Lautstärke verändert auch den Klang. Dem versucht man im Sampler gerecht zu werden, indem man für unterschiedliche Lautstärken auch unterschiedliche Samples verwendet - dabei kenne ich bisher noch keinen Versuch, wirklich jeden der 127 MIDI-Velocity-Werte in einem eigenen Layer unterzubringen.

- Ein zweiter, sehr ähnlicher Aspekt betrifft die unendliche Anzahl möglicher Orte, an denen der Schlagzeug-Stick auftreffen kann. Jede Stelle auf dem Becken ergibt einen anderen Klang - man findet da sehr subtile Variationen neben solchen, die sehr deutlich wahrnehmbar sind, wenn man etwa an die Glocke denkt. Digital läßt sich dies allenfalls durch unterschiedliche MIDI-Noten realisieren - tatsächlich gehen bessere digitale Drums diesen Weg, indem sie eine Schlagfläche in mehrere Zonen aufteilen, über die wiederum unterschiedliche Samples getriggert (angestoßen) werden. Wieder ist dies allenfalls ein Abglanz der analogen Komplexität.

- Zum dritten wäre selbst dann, wenn man mit völlig identischer Lautstärke exakt dieselbe Stelle träfe, der zweite Schlag komplett anders als der erste, und der dritte und vierte immer wieder unterschiedlich. Der Grund ist, daß der Stick jetzt in eine schwingende Fläche schlägt - und zwar in eine Schwingung, die sich kontinuierlich und chaotisch aufbaut und ändert. Digital läßt sich dieser letzte Punkt überhaupt nicht nachstellen.

Ähnliche Probleme findet man aber auch bei der Simulation aller anderen Instrumente - sehr ausgeprägt noch ausgerechnet beim für die Popmusik eigentlich wichtigen Saxophon, vergleichsweise unkritisch hingegen beim durch das Wirken der Mechanik eh schon fast automatisierten Klavier. Ich will nicht behaupten, daß es einfach wäre, ein Klavier zu sampeln - eher stimmt wohl die Vermutung, daß es hier auch heute nicht möglich ist, ein geübtes Gehör zu täuschen. Dennoch ist die Simulation eines Klaviers eine letztlich banale Angelegenheit, wenn man das mit anderen Instrumenten vergleicht.

Synthesizer

Synthesizer sind keine Sampler - auch wenn selbst die Hersteller von Musik-Equipment das fast schon vergessen haben. Mit dem puren Abfeuern von Sounds hat man die Möglichkeiten nicht einmal angekratzt, die elektronische Musikinstrumente bieten.

Ein Synthesizer ist, wie es schon der Name nahelegt, ein Gerät, mit dem man sich eigene Klänge zusammenbauen kann. Dabei hat man es zunächst mit rein analogen Klangerzeugern (den VCO's) zu tun, die auf elektronischem Weg Schwingungen produzieren. Man kann unterschiedliche Wellenformen wählen, die sehr unterschiedlich klingen: Sinus-, Rechteck- oder Sägezahnwelle sind wohl die bekanntesten Beispiele, die sich schon auf den ersten Moog-Synthis finden. Diese Klänge kann man in ihrer Tonhöhe verändern, und zwar nicht nur durch die Oktaven und Halbtöne ("pitchen"), sondern auch in ganz leichten Nuancen ("tunen"). Indem man mehrere solcher Tonerzeuger parallel fährt, lassen sich bereits recht komplexe Klänge "mischen" ("additive Synthese").

Zu einem echten Synthi - bisher haben wir erst eine elektronische Orgel - wird das Ganze erst, wenn Module hinzukommen, die nicht Klang, sondern Kontrollinformationen generieren - Oszilatoren etwa, die auf Lautstärke, Tonhöhe oder Frequenzverlauf wirken. Das wichtigste dieser Module [1], der Hüllkurvengenerator oder ADSR, bestimmt den Lautstärkenverlauf eines Tons (Diagramm - Quelle: Wikipedia); in der Attack-Phase etwa wird darüber entschieden, ob man es bspw. mit einem hart einsetzendem ("Piano") oder einem weich einschwingenden Klang ("Streichorchester") zu tun hat. - Dabei lassen sich diese Module miteinander elektrisch so verschalten, daß etwa der Ausgang eines Moduls, das sehr langsame Schwingungen generiert (LFO), zum Eingang eines VCO wird und dessen Lautstärke moduliert. Ich will nicht in die Details gehen - aber man kann selbstverständlich(!) auch den Ausgang eines ADSR auf den Eingang eines LFO legen (und damit der Lautstärkenmodulation einen Verlauf geben), oder umgekehrt (den Verlauf der Lautstärke modulieren). Die Varianten sind unendlich, und von drastischem Einfluß auf den resultierenden Klang.

Das Ganze funktioniert nicht nur mit analoger Elektronik, sondern auch mit digitalen Klangerzeugern. Ein Beispiel ist der DX7 von Yamaha, der mit seinem Konzept der FM-Synthese echtes Neuland betrat (1983). Die grundlegenden Klänge werden nicht mehr vom VCO generiert, sondern von sechs Modulen, die lediglich reine Sinuswellen produzieren. Der Witz besteht hier darin, daß diese Module als "Operatoren" (Klangerzeuger) oder "Modulatoren" auftreten können, wobei letztere auf ein Operator-Modul geschaltet werden und dessen Frequenzverlauf (FM = Frequency Modulation) beeinflussen. Indem sich diese sechs Module zu einer ganzen Reihe von Algorithmen verknüpfen lassen [2], sind unglaublich komplexe Klänge möglich - die man hinterher noch mit dem bekannten Instrumentarium (ADSR, LFO, VCA, VCF, etc.) bearbeiten kann. - Richtig abgefahren wird es in den Nachfolgern [3], wenn die Module nicht nur Sinus-, sondern alle möglichen anderen Wellenformen abfeuern können - und dann auch noch gesampelte Klänge. Man stelle sich einen Sound vor, der auf einem Flötensample basiert, das von einem Cellosample moduliert wird - das erinnert nicht etwa an eines der Originale, sondern stellt etwas völlig Neues vor (wobei dieses Extrembeispiel einfach nur scheußlich klingen dürfte).

Leider ging mit der immer stärkeren Verbreitung von elektronischen Musikinstrumenten auch eine Verflachung der Konzepte einher. Immer mehr wurde es für die Hersteller wichtig, schon werkseitig Sounds anzubieten, die potentielle Käufer schon beim ersten Test des Instruments im Musikgeschäft beeindrucken konnten, statt mit innovativen Konzepten der Klangerzeugung auf sich aufmerksam zu machen. Schon im DX7 waren die vorprogrammierten Sounds häufiger in Studioproduktionen anzutreffen, als solche, die die User selbst kreiert hatten - legendär ist der Ruf des DX7, vom Laien nicht programmierbar zu sein, und selbst dem versierten Sounddesigner unvorhersehbare Überraschungen zu bieten [4]. Nach und nach gewannen dann sog. "Workstations" einen immer größeren Marktanteil, die sich durch eine große Auswahl an vorprogrammierten Klängen auszeichneten, auf die der User wenig oder auch gar keinen Einfluß mehr hatte. Einen gewissen Schlußpunkt in dieser Entwicklung ist die Einführung des GM ("General MIDI")-Standards, der 128 Sounds in 8 Bänken definiert, die in allen Geräten, die diesem Standard folgen, implementiert sein müssen: acht unterschiedliche Pianos, acht Gitarren, usf. Das ist praktisch, wenn man MIDI-Files tauschen oder publizieren will - für die Entwicklung der Synthis war das der endgültige Übergang in die Ära der "ROMpler": Geräte, die ausschließlich Samples abfeuern - mehr ein neuer Spaß im versammelten Multimedia-Spektakel, als Musikinstrumente.

- [1] Glossar:

VCO: Voltage Controlled Oscillator (Tonerzeugung)

ADSR: Attack/Decay/Sustain/Release (Hüllkurvengenerator - Lautstärkeverlauf eines Klanges)

LFO: Low Frequency Oscillator (Vibrato)

VCA: Voltage Controlled Amplifier (Modulation der Lautstärke)

VCF: Voltage Controlled Frequency (Modulation der Frequenz - Stichwort "Filtersweeps")

- [2] Alle sechs Module als Operator, oder drei Operator-Module mit jeweils einem aufgeschalten Modulator, aber auch ein Modulator, der einen Modulator moduliert, der endlich einen Operator moduliert, etc.pp.

- [3] Ein TG77 vom Anfang der 90er steht noch neben meinem Schreibtisch.

- [4] Diese Meinung kann nur daraus resultieren, daß kaum jemand großartig bemüht war, sich mit der Sache ein wenig auseinander zu setzen.

Virtuosen

Sounds aus dem Synthesizer sind immer nur so gut wie der, der sie spielt. Man kann zwar Klänge bauen, die in sich unglaublich reich und komplex sind und allein dadurch zum Leben zu kommen scheinen, daß sie von LFO's oder VCF's auf vielen Ebenen moduliert werden - letztlich merkt man einem Klang, der über längere Zeit nur statisch steht, rasch an, daß er von einer Maschine produziert wird; und ein Solosynth kann noch so sehr mit dem Schmutz und der Wildheit einer verzerrten Gitarre prahlen, wenn man ihm letztlich die festgenagelten Tonhöhen einer Klaviertastatur anhört.

Es gibt eine ganze Reihe von Spielhilfen, mit denen man während des Spiels auf die Sounds Einfluß nehmen kann. Zunächst gibt es das allbekannte Pitchwheel, mit dessen Hilfe man stufenlos an der Tonhöhe drehen kann. Wenn man das richtig macht, kann man Streicherglissandi oder das Ziehen an einer Gitarrensaite so nachmachen, daß der Zuhörer als letztes darauf tippen würde, es mit einem Tasteninstrument zu tun zu haben (wobei der Effekt heute natürlich jedem bekannt ist). Dabei geht es gar nicht darum, den Hörer zu täuschen, sondern Spieltechniken nachzubilden, die einen bestimmten Ausdruckscharakter haben.

Daneben kann man eine ganze Serie von Spielhilfen nutzen, mit denen der Spieler auf die Klangerzeuger letztlich ebenso Einfluß nimmt, wie dies die Operatoren tun: sie können als Eingang jedes nur denkbaren Moduls dienen und LFO, VCA, VCF etc. ersetzen oder ergänzen. - Zunächst wäre dies - als zweiter Drehregler meist neben dem Pitchbend montiert - das Modulationsrad, mit dem man den Lautstärkeverlauf oder Filter verändern kann (als manuell gesteuertes Vibrato oder Modulation), aber prinzipiell auch jedes andere Modul.

Eine andere Spielhilfe ist Aftertouch: das Drücken auf die Tasten, während man einen Ton oder Akkord hält. Normalerweise steuert man damit einen Controller, der auf das gesamte Keyboard wirkt - es gibt aber mit dem sog. polyphonen Aftertouch auch eine Variante, mit der man jeden einzelnen Ton unterschiedlich modulieren kann (wenn man sich den Soundtrack vom Blade Runner ins Gedächtnis ruft: die Sounds von Vangelis sind ohne dieses Feature undenkbar - und weil es nur sehr selten implementiert wurde, sind sie direkt mit dem Yamaha CS-80 assoziiert).

Darüber hinaus gibt es alle möglichen anderen Varianten, ob das nun Breath- oder Ribbon-Controller sind, oder ob man ganz andere Instrumente (Gitarre, Blasinstrumente - im YouTube-Video weiter unten spielt der - viel zu früh verstorbene - Michael Brecker das Akai-EWI) als Vorbild nimmt, um MIDI-Controller zu bauen, die vom Plektrum oder dem Mund betrieben werden - es ist müßig, das im einzelnen aufzuzählen.

Festzuhalten bliebe, daß es ständig neue Versuche gab und gibt, die Schnittstelle zwischen Mensch und Maschine neu zu definieren, um dem Musiker Möglichkeiten zu geben, in Echtzeit Einfluß auf den Klang zu nehmen. Letztlich unterscheiden sich Synthesizer in dieser Hinsicht nur wenig von den "klassischen" Instrumenten: um wirklich gut zu klingen, braucht es einen Virtuosen, der sie spielt.

(Um einem kommenden Blogeintrag vorzugreifen: nicht jeder Cellist spielt wie Mischa Maisky - und selbst wenn ich seine Telefonnummer wüßte, wäre es mir kaum möglich, ihn dazu zu bewegen, mal in der Semperstraße vorbeizukommen und ein paar Takes einzuspielen.)

Patterns

Richard Wagner hat seine Opern in drei Schritten entwickelt: am Anfang stand die eigentliche Komposition, wobei er immer ein Klavier (genauer: einen Flügel von höchster Qualität) neben sich stehen hatte (das ist bemerkenswert u.a. deshalb, weil Beethoven seine vielleicht bedeutendsten Werke schrieb, als er taub war). Dabei hat er nur die Gesangsstimmen in einzelnen Systemen notiert; das Orchester war zunächst auf ein Klaviersystem beschränkt. Zwar gab es schon Anmerkungen und Ideen für die Orchestrierung - die fand aber erst in einem zweiten Schritt, bei der Niederschrift eines Particells statt, in dem die einzelnen Instrumentengruppen auf je ein Klaviersystem beschränkt waren, und in denen allenfalls Notizen zu den konkreten Instrumenten auftauchten. Erst im letzten Schritt wurde die komplette Partitur erstellt - Wagner hat behauptet, daß dies eine Arbeit sei, die sich automatisch aus dem Particell ergebe, hat aber nie jemanden gefunden, der ihm diese Arbeit abgenommen hätte (da es Notenpapier mit der - zu seiner Zeit unvorstellbaren - Anzahl von Systemen, wie er sie benötigte, nicht zu kaufen gab, mußte er die Notenlinien selber auf ein leeres Blatt zeichnen; trotz eines langen Arbeitstages hat er selten mehr als eine Partiturseite pro Tag geschafft - der "Tristan" hat ihn fünf Jahre beschäftigt, davon allein ein Jahr beim "Malen" der Partitur).

In den Anfängen der Komposition am Computer hatte man es mit "Patterns" zu tun - Einheiten von einer bestimmten Länge (gerade ein bis zwei Takte in den frühen analogen Sequenzern), in denen alle Spuren (Instrumente) definiert waren, und die man hinterher zu einem "Song" zusammenbasteln konnte. Die Beschränkung auf MIDI hinzugenommen, führte dies dazu, daß man dieses Pattern ständig im Kreis ("Loop") spielen ließ, und einen Sound nach dem anderen hinzufügte. Waren bei Wagner "Komposition" und "Instrumentation" klar voneinander getrennte Schritte, vermischen diese beiden Aspekte sich zunehmend - mehr noch: auch die Aufführung eines Werks findet zunehmend gleichzeitig statt, wenn am Computer auch das Endresultat "abgemischt" wird.

Wenn man ein Pattern fertiggestellt hat, kann es leicht passieren, daß man durch den Gesamteindruck des ersten Teils nicht mehr in jene eher abstrakte Schicht zurückfindet, mit der man z.B. eine Akkordfolge am Klavier sucht - man hat eine perfekte Strophe, findet aber partout keinen dazu gehörigen Refrain - immer vorausgesetzt, daß man immer noch in letztlich klassischen Formverläufen denkt und z.B. etwas wie "Songwriting" betreibt. Immer mehr aber macht sich das Produktionsverfahren selbstständig und schleicht sich in die Musik selber ein: Loop-basierte Musik ist definitiv eine Erfindung der Computermusiker, die es - zumindest in dieser auf ein oder zwei Takte beschränkten Kleingliedrigkeit - zuvor nicht gegeben hat. Es liegt ganz einfach nahe, (komplexe) Patterns zu kopieren und danach die Kopie zu editieren, statt für eine Fortsetzung wieder mit einem komplett leeren Pattern zu beginnen - zumal das Verfahren sich schon in den Ohren festgesetzt hatte, weil auf den analogen Sequenzern gar nichts anderes zu haben war.

Latenz

Es gibt zwei unterschiedliche Strategien, wenn man ein Programm schreiben will, mit dem man am Computer Audiodateien abspielen, aufnehmen, und editieren kann. Bei der einen wird jedes einzelne Sample getrennt berechnet; bei der anderen wird ein größerer Speicherblock aus mehreren Samples in einem Rutsch bearbeitet.

Die ältesten Verfahren sind Sample-orientiert (was nicht heißt, daß dies überholt wäre). Sie basieren auf spezieller Hardware - DSP-Chips, die auf die Bearbeitung von 16-Bit-Daten spezialisiert sind und zudem einen (im Vergleich zu einer CPU) stark reduzierten Befehlssatz haben, dafür aber über eine Reihe Features verfügen, die sie echtzeitfähig machen.

Block-orientiertes Vorgehen hingegen ist seit Mitte der 90er Jahre auch auf der CPU eines gewöhnlichen PC lauffähig - es ist wesentlich einfacher zu optimieren, weil die Vorbereitungen für die Berechnungen nur einmal für einen kompletten Block aus mehreren hundert (oder tausend) Samples durchlaufen werden müssen, statt immer wieder für jedes einzelne Sample - letzteres verlangt einen Chip, der ausschließlich mit der Berechnung von Audio beschäftigt ist, während ersteres sich auch als Hintergrundtask für die Haupt-CPU - die ja auch andere Dinge, wie Userinput und GUI zu verarbeiten hat - programmieren läßt.

Es ist klar, daß Block-orientierte Verfahren im Resultat wesentlich billiger für den Enduser sind, weil dieser keine neue Hardware anschaffen muß. Tatsächlich kam es zum Siegeszug der Audiobearbeitung für das Homerecording erst, als Steinberg mit VST und ASIO zwei Standards etablierte, die sich mit der Rechenleistung der Haupt-CPU bescheiden - und die auf dem Processing von Sample-Blöcken basieren.

In der professionellen Szene hat sich dieser Ansatz jedoch bis heute nicht durchgesetzt. Wer etwas auf sich hält, hat ein ProTools-System von Digidesign in seinem Tonstudio installiert, sprich: (sehr) teure Hardware. Ein entscheidendes Argument ist die Tatsache, daß man hier keine Probleme mit Latenz hat - ein Signal, das man in den Eingang der Hardware schickt, kommt mit nur einem Sample Verzögerung am Ausgang wieder an, und zwar mit sämtlichen Berechnungen für das Mixing und für die Effekte. Für die Wiedergabe ist dies zwar ohne Bedeutung - die Block-orientierte Konkurrenz löst das Problem, indem sie die Abspiel-Engine in die Zukunft vorverlegt, d.h. vorberechnete Buffer bereit stellt, die auf Anforderung ohne Zeitverzögerung ausgegeben werden können. Anders sieht das bei der Aufnahme aus: wenn man einem Sänger oder Gitarristen das mit Halleffekten oder einer Verstärkersimulation bearbeitete Signal auf den Monitor legen will, sind Verzögerungen von mehreren Millisekunden, wie sie in der Block-orientierten Verarbeitung zwangsläufig auftreten, inakzeptabel. Wenn ein Gitarrist sich erst hört, nachdem er die Saite längst angeschlagen hat, dürfte es ihm unmöglich werden, korrektes Timing oder gar Groove an den Tag zu legen.

Ganz zu Beginn - Anfang der 90er - hatte dieses Argument zweifellos seine Berechtigung, betrugen die Latenzen doch 30ms und mehr. Es gilt: je geringer die Latenz, desto kleiner die Blöcke, und desto schlechter die Performance - wobei sich mit den heutigen Multi-Core-CPUs Latenzen im einstelligen Millisekunden-Bereich realisieren lassen. Mein System erlaubt ruckelfreies Playback bei gleichzeitiger Aufnahme mit einer Latenz von 10ms - theoretisch machbar sind auch 4ms, wobei dann aber die Wiedergabe Aussetzer hat. Aufgrund der subtilen Schwankungen im Timing, die so etwas wie eine "groovende" Performance von schlechtem Spiel unterscheiden, scheint aber auch eine Latenz von 10ms inakzeptabel.

Die Mathematik sagt aber etwas anderes. Die Schallgeschwindigkeit beträgt 343 Meter/Sekunde, das sind 3,4 Meter in 10ms. Wenn ich mit der (E-)Gitarre 3,4 Meter von meinem Verstärker entfernt stehe, habe ich genau die zur Frage stehende Latenz: ich höre mein eigenes Spiel mit einer Verzögerung von 10ms. Wenn das tatsächlich ein Problem sein sollte, wäre jedes Rockkonzert ein Ding der Unmöglichkeit - dort stehen die Musiker teilweise zehn oder noch mehr Meter von den Monitoren entfernt, von Ausflügen in Randbereiche der Bühne ganz zu schweigen.

Dabei sieht man immer wieder Musiker, die mit einem Knopflautsprecher im Ohr unterwegs sind, und genau an diesem Problem zu leiden scheinen. Gerade Sänger sind es gewohnt, den Klang der eigenen Stimme direkt im Kopf, im eigenen Körper zu erleben. In einer Konzert- oder Aufnahmesituation ist dies nicht mehr der Fall, weil der Rest der Band schlicht zu laut ist. Mit einem Monitor (der auch nur eine Mischung der gesamten Band wiedergibt) läßt sich dieser fehlende Körperbezug aber nicht simulieren - deshalb, in erster Linie, der Knopf.

Ein Gitarrist ist meiner Erfahrung nach definitiv in der Lage, sich an solche Latenzen anzupassen. Ich habe in meiner aktiven Zeit beim Soundcheck gelegentlich mit einem langen Kabel einen Ausflug in den Zuschauerraum unternommen, und hatte dabei noch keine Probleme, weiter mit der Band zu spielen. Es fühlt sich schon etwas besser an, wenn man direkt vor dem Verstärker steht - wobei das noch immer nicht das Problem löst, daß die Verstärker der anderen zwangläufig in einer gewissen Distanz stehen. Das Ohr ist aber wesentlich anpassungsfähiger, als der Streit um die Latenz suggeriert.

Schließlich gibt es einen einfachen Trick, um die von der Software generierten Latenzen bei der Aufnahme komplett los zu werden: man geht über ein externes Mischpult, und schickt dessen Ausgang an den Computer - und parallel dazu auch an den Monitor. Man kann dann immer noch einen gewissen Anteil aus dem Computer zum Monitor hinzu mischen - ob ein Halleffekt 10ms früher oder später einsetzt, ist definitiv unproblematisch.

Es bleibt die Frage, warum die Profis nach wie vor Unsummen in ihre ProTools-Systeme investieren, obwohl objektiv alles dagegen zu sprechen scheint. Es würde den Rahmen des Themas sprengen, wenn ich eine begründete Antwort versuche - letztlich sind es m.E. keine rationalen Gründe, die zu solchen Präferenzen führen (wenn man von Gründen der Kompatibilität mit anderen Studios absieht, die freilich großes Gewicht haben), sondern Vorurteile, die wiederum historische und soziale Wurzeln haben. Ich komme auf das Thema in einem anderen Kontext zurück.

PPQ, BPM, und Samplerate

Es gibt zwei grundlegende Konzepte, mit denen zeitliche Verläufe in einem Sequenzer dargestellt werden können: das eine ist PPQ-, das andere Time-basiert. PPQ oder „Pulses per Quarter” sind dabei die „musikalische” Art und Weise: man denkt in relativen Abständen zwischen den Viertelnoten, deren konkrete zeitliche Platzierung sich erst durch einen weiteren Parameter ergibt, dem Tempo, bzw. BPM, „Beats per Minute”. Im Gegensatz dazu begründet sich eine Time-basierte Darstellung auf einem vom Tempo unabhängigen Raster: dort kann man die zeitliche Ebene konkret in Minuten und Sekunden ablesen.

Die PPQ-Welt ist die ältere, und geht einher mit der Verarbeitung und Darstellung von MIDI-Events. Diese sind ja nur punktuelle Ereignisse, die externe Geräte steuern, wodurch es ein leichtes ist, das Tempo zu verändern, in dem sie abgespielt werden. Deshalb setzt man lediglich relative „Time-Stamps” (Zeitmarken), und verrechnet das mit einem vom User jederzeit veränderbaren Tempo. Dann wird es nicht nur möglich, schwierige Passagen langsam aufzunehmen, um sie deutlich schneller abzuspielen - man kann auch am zeitlichen Verlauf Einfluß nehmen, um etwa einer Performance nachträglich agogischen Ausdruck zu verleihen.

Das ist in der Welt von Audio zunächst noch ganz anders: eine einmal aufgenommene Audiodatei wird in einem fixierten Tempo abgespielt - man hat es hier letztlich nicht mit einzelnen Events zu tun (es sei denn, man definiert eine komplette Audiodatei als Event), sondern mit einem Datenstrom aus zahlreichen Samples, die in einem fixen Abstand aufeinander folgen. Die „Samplerate” (also die Anzahl von Samples pro Sekunde) ist zwar eine Größe, die man verändern kann - dies dann aber nicht nur in Bezug auf das Tempo, sondern gleichzeitig auch auf die Tonhöhe. Wenn man eine Audiodatei schneller abspielt, als sie aufgenommen wurde, kommt es zum „Mickey-Maus-Effekt”, den man von einer schnell drehenden Schallplatte oder einem zu rasch abgespielten Tonband her kennt. Es sind aufwendige Verfahren nötig, um diesem Effekt entgegen zu arbeiten, und auch die besseren von ihnen verursachen selbst heute noch Artefakte, die man zumindest bei extremeren Tempoänderungen sofort hören kann.

Es gibt eine ganze Anzahl von Problemen, wenn man versucht, diese beiden Welten in einem einzigen Programm zu vereinen - und genau dies tun heutige Sequenzer[1].

Die ersten Versuche der Integration von Audio und MIDI unternahm man in rein PPQ-orientierten Programmen: die Audiodateien wurden an einem bestimmten PPQ-Wert gestartet (z.B. auf der »1« des fünften Takts), wodurch dieser Startpunkt abhängig vom Tempo war. Danach spielten sie in ihrer eigenen Welt weiter - ohne Rücksicht auf spätere Tempoänderungen. Abgesehen davon, daß es keinerlei Möglichkeit zur Synchronisierung mit den parallel spielenden MIDI-Events gibt (dies ist selbst heute letztlich nicht anders), wird es auch schwierig, geschnittenes Material so einzustarten, daß es keine Artefakte zwischen den Schnitten gibt - mit einer PPQ-Auflösung kommt man selbst dann nicht zu einer akkuraten zeitlichen Adressierung jedes einzelnen Samples in jedem beliebigen Tempo, wenn sie sehr hoch ist[2].

Das ist ein entscheidender Punkt: Sample-genaues Schneiden von Audio-Events (und das ist die Grundlage für jedes Editing in diesem Bereich) ist nur dann möglich, wenn man sich von der PPQ-Welt verabschiedet, und mit einem „Lineal” arbeitet, das Time-basiert funktioniert.

- [1] Auch ein drittes Medium - Video - wird mittlerweile vielfach unterstützt. Das ist in diesem Rahmen unerheblich, weil sich Audio und Video bezüglich ihrer „Time-Domain” nicht unterscheiden: beide sind im Tempo nicht (ohne weiteres) veränderbar, und gehören deshalb zur Time-basierten Sphäre.

- [2] Frühe (Hardware-)Sequenzer hatten eine Auflösung von 48 PPQ. Cubase ist mit 96 PPQ gestartet, und brachte es in »VST 5.0« Ende der 90er auf stolze 1920 PPQ. Damit kommt man zwar nah heran an die Auflösung von Samples, hat es aber immer mit Rundungsfehlern zu tun.

Einschneidende Konsequenzen hat der Unterschied zwischen der Time- und der PPQ-basierten Welt nicht nur für die Rhythmik, sondern für alle möglichen anderen Ebenen. Man braucht ein musikalisches Raster (im Folgenden: Grid), auf dem die Events angeordnet sind, für ganz grundlegendes Editing: Parts müssen auf Taktgrenzen starten und enden, wenn man in die Formverläufe eingreifen will, und Noten müssen sinnvollen musikalischen Punkten zugeordnet sein, wenn man sie verschieben oder quantisieren will - selbst Veränderungen von Lautstärke oder Tonhöhe sind zwar auch ohne Bezug auf ein Grid möglich, fühlen sich dann aber außerordentlich seltsam an.

Time-basierte Audiodateien sind (zunächst) im Tempo nicht veränderbar, und auch wenn zunehmend besser funktionierende Timestrech-Algorithmen diese Limitierung immer mehr aufheben, bleibt es eine heikle Aufgabe, solches Streching so durchzuführen, daß musikalisch sinnvolle Ergebnisse dabei herauskommen. Dabei sind es nicht nur die unvermeidlichen Artefakte, die brauchbare Ergebnisse nur in einem limitierten Rahmen erlauben. Bei jeder (größeren) Tempoänderung ergibt sich die Notwendigkeit, das Material hinterher anzupassen. Wenn man z.B. das Tempo halbiert, werden all die ursprünglich nicht wahrnehmbaren rhythmischen Ungenauigkeiten einer Live-Performance gelegentlich derart dominant, daß man einzelne Noten korrigieren will - und da stößt man in der Bearbeitung eines Audio-Streams auf die nächste (nahezu) unüberwindliche Grenze.

Ganz anders ist dies in der PPQ-Welt: schon die Definition (Pulses per Quarter) macht deutlich, daß man es hier mit einem genuin musikalischen Konzept zu tun hat - die „Ticks” (Pulses), die hier definiert werden, sind bereits so etwas wie ein rhythmischer Puls (wenn auch in einer sehr feinen Auflösung). Die Veränderung des Tempos ist so fest in diesem Konzept verankert, daß man immer beide Informationen braucht, um die absolute Position (z.B. in Millisekunden) eines Events zu beschreiben: nämlich PPQ-Position und das Tempo an dieser Position.

Dies hat zwei Konsequenzen - eine, die eher auf dem technischen Level Probleme mit sich bringt; und eine zweite, die enormen Einfluß auf die ästhetische Gestalt der Musik nimmt, die seit Mitte der 80er zur Popkultur gehört.

Der Tempoverlauf einer Sequenz wird von einer speziellen Spur (Track) beschrieben; in »Cubase« hieß dies früher sehr schön sprechend „Mastertrack”. Die dort abgelegten Events beschreiben entweder absolute Sprünge im Tempo, oder aber einen Anker für einen kontinuierlichen Verlauf. Entscheidend ist hier jedoch, daß sie ihrerseits Timestamps haben, die in PPQ angegeben werden. Das führt zu dem äußerst irritierendem Umstand, daß ihre absolute Position durch die vorangegangen Tempo-Events bestimmt werden, und sie ihrerseits die absolute Position aller nachfolgenden Events festlegen. Wenn der User versucht, sie zu editieren, ist dies relativ problemlos, solange er sich in der PPQ-Welt aufhält. Versucht er dasselbe in einer Time-basierten Umgebung, wird es außerordentlich schwierig, das Editing so zu programmieren, daß die Umgebung sich halbwegs plausibel verhält: mit jedem Verschieben eines Tempo-Events verändern sich nämlich Position und Größe der Parts und Noten, und entziehen der graphischen Darstellung jeden Boden. Wenn man z.B. Drag&Drop so implementieren würde, daß die graphische Darstellung bei jeder Mausbewegung aktualisiert wird (was ja eigentlich selbstverständlich so vom User erwartet wird), hätte man es mit einer ständig flackernden Umgebung zu tun, wo selbst die Position des Mauszeigers sich ständig ändern müßte. - Ich deute das hier nur an; ein Indiz dafür, wie kompliziert dieses Thema ist (obwohl man es mit gerade zwei einander bedingenden Ebenen zu tun hat), findet sich in dem Umstand, daß der Tempotrack in Cubase lange Jahre nur in einem speziellen Editor, nicht aber im Arrange-Fenster zu editieren war.

Der zweite, wesentlich durchschlagendere Effekt besteht freilich darin, daß alles, was man man „live” mit einem Sequenzer-Programm in den Computer einspielt, zwangsläufig immer dem Diktat eines Metronoms unterliegt. Der „Klick” ist hier zwingend, und es gibt letztlich keinen Workaround, mit dem man ihn umgehen könnte - außer, man verzichtet auf jede Möglichkeit musikalischer Nachbearbeitung, beschränkt sich auf Aufdiorecording, und benutzt den Computer als reinen Tonbandersatz. Spätestens, wenn man Audio und MIDI mischt, braucht man ein Recording, das dem Klick folgt. - Dies gilt selbst dann, wenn man sich nur in die Lage versetzen will, in einer reinen Audioproduktion im nachhinein Formverläufe zu verändern, um z.B. einen Refrain nur einmal aufzunehmen, und ihn später durch Copy&Paste an die richtigen Stellen zu setzen.

Der Grund ist recht einfach: man braucht ein musikalisches Raster (s.o.), und das bekommt man nur in der PPQ-Welt - mit der Konsequenz, daß immer das Tempo bekannt sein muß.

Für das Recording bedeutet dies, daß nur ein vorher festgelegtes Tempo es erlaubt, den aufgenommenen Events sogleich eine PPQ-Position zuzuordnen. Im Nachhinein ist dies nämlich nahezu unmöglich - es sei denn, der User ist bereit, mit größtem Aufwand den Tempotrack im nachhinein anzupassen. Es gibt bis heute kein Verfahren, um aus einem Datenstrom, der aus Events mit absoluten Positionen besteht, nachträglich PPQ und Tempo zu berechnen - und dies hat ganz erhebliche Auswirkung auf die Musikkultur der letzten fünfundzwanzig Jahre.

Beispiel (Kinderlied). Die Noten sehen in allen drei folgenden Szenarien immer gleich aus:

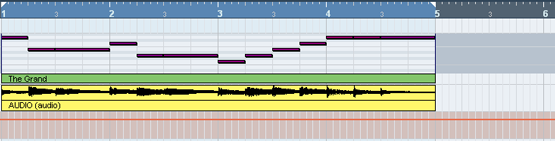

1) Dieselben vier Takte werden im Key-Editor als (dunkel-eingefärbte) Balken dargestellt; darunter sieht man die Wellenform der Audiodatei (gelb), die aus einem „Mix-Down” der MIDI-Aufnahme entstand. Die beiden Spuren klingen hier exakt gleich - man kann zumindest gut erkennen, daß die „Peaks” des Audio mit den Anfängen der Noten im Key-Editor synchron sind - auch das Ende der vier Takte ist gleich. Im Track ganz unten (rot) sieht man, daß das Tempo fix bleibt (bei 182 BPM).

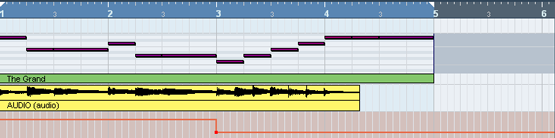

2) Jetzt wird das Tempo im dritten Takt verändert - es geht auf 120 BPM zurück. Wohlbemerkt: Audio und MIDI klingen jetzt nicht mehr synchron. Das Audio spielt genauso ab wie zuvor, während der MIDI-Track ab Takt drei langsamer wird.

Die Darstellung im Key-Editor (der MIDI-Daten zeigt) verändert sich nicht - diejenige vom Audio aber in der zweiten Hälfte sehr deutlich. Warum? Weil die Darstellung PPQ-basiert ist, d.h., der Abstand zwischen zwei Ticks verändert sich nicht, obwohl der „absolute” zeitliche Abstand ein anderer ist.

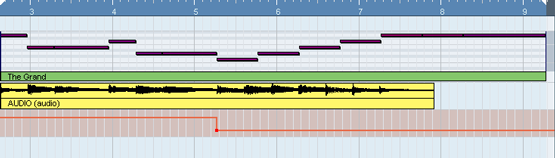

3) Im letzten Bild hat sich an den Daten und im Tempotrack im Vergleich zu (2) nichts verändert. Dafür orientiert sich die Darstellung nicht mehr an der PPQ-Welt, sondern zeigt ein gleichförmiges Raster aus Sekunden. Man sieht also jetzt erst, wie der zeitliche Verlauf tatsächlich ist: im Audio hat sich nichts geändert, die MIDI-Daten hingegen werden langsamer abgespielt. - Der musikalische Sinn geht hier jedoch verloren - selbst ein Kinderlied bei gerade einem Tempowechsel ist letztlich nicht mehr wiederzuerkennen, geschweige denn editierbar.

Ich habe mich schon im Rhythmus-Baukasten damit beschäftigt, welche ästhetischen Auswirkungen die Allgegenwart der „objektiven Time” hat, deren gleichförmiger Puls nahezu jede Musikproduktion am Computer prägt und ihr Entstehen an der Maschine offenkundig werden läßt. Dabei stand bislang meine Behauptung im Raum, „objektive Time” wäre dem Computer inhärent, ohne daß ich dies letztlich begründen konnte.

Man muß zunächst festhalten, daß es nicht die Digitalisierung der Daten ist, die „objektive Time” erzwingt. Man kann eine Live-Performance mit dem Computer so aufnehmen, daß ihre Agogik komplett erhalten bleibt - die Wahrnehmungsschwelle des menschlichen Ohres liegt weit unterhalb der Quantisierung, die das Zerlegen von akustischen Ereignissen in digitale Samples bedeutet. Wenn das anders wäre, müßte man Unterschiede in rhythmischer Hinsicht zwischen einer CD und einer Schallplatte hören - und das ist definitiv nicht der Fall.

Zunächst finden sich historische Gründe, daß man PPQ-basierte Darstellung und Bearbeitung heute für völlig selbstverständlich hält. Die Vorfahren der modernen Computerprogramme - die ersten analogen Sequenzer und Drummachines - bestanden aus einer oder mehreren Reihen von 16 oder 32 Knöpfen oder Reglern, mit denen man jeweils ein rhythmisches Ereignis festlegen konnte: man aktivierte bspw. den 1. und 9. Knopf für die Bassdrum, den 5. und 13. für die Snare, und definierte so die schweren Zählzeiten eines auf Sechzehnteln basierenden Taktes. Mit einem getrennten Regler konnte man dann das Tempo einstellen. Schon hier findet man all jene grundlegenden Bedienelemente, die auch heute noch eine Rolle spielen - freilich in einer so groben Auflösung, daß harte Quantisierung bereits voreingestellt war und gar nicht umgangen werden konnte.

In der Folge ließ sich das stark dynamisieren. Schon mit den ersten Hardware-Sequenzern Mitte der 80er ließen sich Tickabweichungen und Temposchwankungen programmieren. Bloß: das hat kein Mensch getan. Man war bereits derart auf die quantisierten Grooves eingehört und festgelegt, daß man selbst eine live gespielte Aufnahme zuerst quantisierte. Der Tempotrack spielte schon hier jene Rolle, die er bis heute hat: man hat ignoriert, daß er überhaupt existiert.

Der zentrale Punkt ist jedoch, daß jeder für den Computer am Ende relevante Timestamp in absoluten Sekunden, nicht jedoch in relativen musikalischen PPQ vorliegen muß. Wenn ein Event in den Buffern darauf wartet, an die Hardware geschickt zu werden, muß bekannt sein, zu welcher (Milli- oder gar Nano-)Sekunde dies zu geschehen hat, und das gilt für MIDI-Hardware ebenso wie für die fürs Audio zuständige Soundkarte. Für den User hingegen spielt diese Information nur in bestimmten Sondersituationen eine Rolle (wenn er Geräuscheffekte zu einem Film synchronisiert, z.B. - ich komme darauf noch zurück). Er will Material auf dem Bildschirm sehen, das sich an musikalischen Positionen orientiert, an Taktgrenzen, Beats, oder dem musikalischen Puls. (Fast) jede Darstellung muß sich auf ein PPQ-Grid beziehen. Nur dann kann man vernünftig sowohl Rhythmik wie auch Formverläufe editieren.

Die Umrechnung zwischen musikalischer und objektiver Time ist für einen Computer nur dann möglich, wenn auch die musikalische Time gleichförmig ist. Dazu bedarf es bei jeder Aufnahme am Computer eines Clicks (=Metronoms), der dem Musiker diktiert, wie er zu spielen hat, um diese Gleichförmigkeit zu produzieren. Dies gilt keineswegs nur für den Keyboarder, der MIDI aufnimmt. Wenn man seine Performance mit Aufnahmen von akustischen Instrumenten vermischt, ist es unabdingbare Voraussetzung, daß auch alle anderen zum Click gespielt haben. Selbst bei den allermeisten Produktionen, die ausschließlich Audio-Aufnahmen verwenden, kann man hinterher ein Metronom mitlaufen lassen, ohne dessen Schlagzahl im Verlauf auch nur einmal korrigieren zu müssen.

Es gab (und gibt?) in der Forschung einige Bemühungen, auch aus live gespieltem, unquantisierten Material nachträglich die „musikalische Time” herauszuziehen. Ich habe mich Ende der 90er mit dem Thema beschäftigt, bin aber rasch an meinen unzulänglichen mathematischen Kenntnissen gescheitert. Seitdem scheint sich wenig getan zu haben - zumindest gibt es jenseits der akademischen Forschung keine allgemein zugänglichen Lösungen. Mir ist jedenfalls kein Programm bekannt, mit dem man Material mit Timestamps in objektiven Sekunden nachträglich mit PPQ-basierter musikalischer Zeit versehen kann.

Das Verschwinden des Auftakts

Nicht nur in Bezug auf die Rhythmik, sondern auch bei der Gestaltung der formalen Struktur haben die Computer nicht einfach die Arbeit erleichtert, sondern auf inhaltlicher und ästhetischer Ebene Veränderungen bewirkt, die letztlich auf eine - stellenweise sehr subtile und nur schwer wahrnehmbare - Verarmung hinauslaufen.

So kann man beispielsweise beobachten, daß auftaktige Themen sehr selten geworden sind. Das hat zunächst gar nichts damit zu tun, daß Popmusik generell dazu tendiert, sehr einfache Formmodelle zu wählen. Auftakte sind - oder waren - ein sehr gängiges Muster, das auch ein ungeübter Hörer ohne weiteres nachvollziehen kann. Sie haben noch in jeder populären Musik eine wichtige Rolle gespielt, ob es sich um die Musicalmelodien der 30er oder die deutschen Schlager der 70er handelt. Sie sind aber bei der Bearbeitung von Musik am Computer außerordentlich unhandlich, weil sie sich dem simplen Schnitt an den Taktgrenzen verweigern. Wenn man eine auftaktige Phrase kopieren oder verschieben will, kann man dies letztlich nur auf der Event-Ebene tun, und muß die wesentlich übersichtlichere Ansicht im Arrange-Fenster verlassen - die Noten, die den Auftakt bilden, überlappen die zunächst klar untereinander liegenden formalen Grenzen, und erzwingen asynchrone Schnitte von Melodie und Begleitung.

Entscheidend hier ist aber die Möglichkeit, das Material in seine Einzelteile zu zerlegen, zu vervielfachen und an neue Stellen zu verfrachten. Man kann der Versuchung kaum widerstehen, einen einmal aufgenommenen Refrain überall dorthin zu kopieren, wo er erneut gebraucht wird, statt sich die Arbeit zu machen, ihn immer wieder erneut aufzunehmen. Ebenso wenig wird man die Begleitung einer Strophe mehrfach einspielen, wenn man denselben Job mit wenigen Mausklicks erledigen kann. Das muß nicht einmal so offensichtlich werden, daß nun jeder dieser Formteile exakt gleich klingt. Es reicht aus, einige nachträgliche Änderungen in der Instrumentierung vorzunehmen, oder eine neue Stimme hinzutreten zu lassen (die vielleicht ihrerseits auf einer Kopie basiert), um den Eindruck der Monotonie gar nicht erst aufkommen zu lassen. Im Hintergrund ist aber solche Monotonie dennoch am Werke, und wenn man darauf trainiert ist, sie zu hören, bemerkt man plötzlich, daß eine Baßphrase in allen Strophen wörtlich wiederkehrt, oder ein Streicher-Arrangement selbst im Detail identisch bleibt. Selbst wenn man das nicht analytisch nachvollziehen kann, bleibt ein fader Nachgeschmack - zumindest für jene, die mit der Hörerfahrung von „handgemachter” Musik sozialisiert wurden, in der Variation selbst bei der Wiederholung immer gleicher Strukturen zwangsläufig gegeben war.

Equipment

Ich hänge an dieser Stelle einige Einträge an, in denen ich mich über mein derzeitiges Equipment geäußert habe - es gehört eher locker zum Thema, mag aber vielleicht den einen oder anderen interessieren. Hinzu kommt, daß ich die Notizen nicht in den Untiefen meines Blogs versinken lassen möchte - für einen eigenen „Baukasten” scheinen sie mir aber dann doch nicht zu taugen.

Computer (Core I7, 4GB Ram, 2 TB Festplatte)

Nachdem mein Heim-Rechner lockere neun Jahre alt geworden ist, wurde es an der Zeit, mit etwas Neuem zuzuschlagen - nicht, weil was kaputt ist, sondern weil Musik-Equipment den Weg komplett in den Computer genommen hat. Heutzutage braucht man kaum noch externe Mischpulte, Effektgeräte, oder auch Synthesizer, dafür aber maximale Resourcen im Computer, sowohl, was Speicherplatz, als auch, was Processing-Power angeht.

Heute morgen kam die Lieferung - und zwar in Einzelteilen. Es wird dadurch nicht wirklich billiger, man bekommt aber genau das, was man will - und meine Vorstellungen weichen von denen der Anbieter von Komplettangeboten doch etwas ab. OK - den Intel Core i7 (die 4x2.6GHz-Variante, also das Einsteigermodell der derzeitig schnellsten CPU's) in Verbindung mit 4GB RAM gibt es auch bei Saturn - aber eben nicht auch noch mit 2 Terrabyte Festplattenspeicher, die aus zwei als RAID-Array geführten Platten bestehen (was die Performance der Platten deutlich verbessert - für die Wiedergabe von hochauflösendem Audio nicht ganz unwichtig), und der schnellsten passiven (d.h. flüsternd-leisen) Grafikkarte.

Die Bastelei fand ich nicht sonderlich schwierig - dabei ist es auch nicht das erste Mal, das ich das mache, obwohl das letzte Mal die erwähnten neun Jahre zurück liegt. Dabei bedeutet es natürlich trotzdem einen Akt innerer Überwindung, zum ersten Mal Strom auf das Gerät zu schalten - obwohl ich die (katastrophal schlechten) Manuals Wort für Wort gelesen hatte, und dreimal kontrolliert hatte, ob alle Kabel richtig liegen, hatte ich durchaus echte Angst, den Power-Knopf zu drücken - wenn man was falsch macht, würden Mainboard und Prozessor unwiederbringlich gegrillt - Erleichterung: alles ging gut.

Es wäre aber zu schön gewesen, wenn alles auf Anhieb geklappt hätte. Zum einen ist die Grafikkarte von einem derart mächtigen passiven Kühler umgeben, daß der die komplette Tiefe des Gehäuses in Anspruch nimmt - da bleibt nicht einmal Raum für den zweiten Lüfter, der an der Außenwand angebracht ist. Beim ersten Startversuch des kompletten Systems gab es ein lautes Geklackere, bei dem mir fast das Herz still stand - der Lüfter hatte mechanischen Kontakt mit der Karte, und mußte wieder raus. - Zum zweiten hatte ich vom Versand (Alternate) im vorhinein die Mitteilung bekommen, daß man die Lieferung in zwei Teile splitten würde, weil das DVD-Laufwerk nicht verfügbar sei. Nicht schlimm, dachte ich: dann nimmst du zum Installieren von Betriebssystem und Software mal kurz das Laufwerk aus dem alten Rechner (den ich nicht ausschlachten, sondern weiterhin benutzen oder komplett verkaufen will). Denkste: die Jungs von der Hardware-Front haben nicht nur das Bussystem der Grafik geändert (was ich vorher wußte), sondern auch zumindest neue Stecker für die Kabel zu den Laufwerken gebastelt - als nächstes muß ich forschen, ob sich dahinter ein neues Bussystem verbirgt, oder ob es Adapter gibt.

Für Beschäftigung über die "Feiertage" ist jedenfalls reichlich gesorgt - ich bin gespannt, ob wenigsten etwas Zeit dazu bleibt, Musik zu machen.

Größenteils ging der Umzug besser als gedacht - daneben gab es aber auch ein paar dumme Überraschungen, und auch eine Sache, die ich bislang nicht in den Griff bekomme.

Der Zusammenbau der Hardware ging wesentlich einfacher, als ich anfangs befürchtet hatte. Die Dokumentation eines Intel-Boards besteht ja bloß noch aus einem DIN A-2-Blatt, auf dem mit lauter Bildchen in Ikea-Manier beschildert ist, was man wohin pflanzen soll - und wider Erwarten reicht das völlig aus. Einzig mit der Grafikkarte habe ich noch zu kämpfen - die verlangt eine Verbindung mit dem SPDIF-Ausgang des Boards (wer sich das ausgedacht hat, gehört erschossen), die ich auch nach einigem Gefummel und Lesen im Internet aufgrund unterschiedlicher Auffassungen von Intel und Asus bezüglich des Layouts des Steckers (3- vs. 4-Pol) nicht hin bekomme. Bislang gibt es jedenfalls bei jedem Systemstart die Warnung, daß die Grafik nur mit verminderter Leistung arbeitet. - Naja.

Auch die Installation des Systems ging überraschend problemlos vonstatten - wenn man davon absieht, daß das Windows-Setup drei Stunden gebraucht hat, die 2.000 GB Festplatte zu formatieren; und wenn man einige frustrierende Versuche vergißt, mit meiner uralt-Windows-CD (XP SP1) zu booten - was nicht mehr geht und dazu führte, daß ich jetzt ein englisch-sprachiges System habe, das zudem noch durch diesen unsäglichen Freischalt-Prozeß mußte. Ernsthaft: das meiste ist heutzutage derart einfach, daß ich mich fast schon unterfordert fühle: CD rein und Treiber fürs Brett (norddeutsch für Mainboard) installieren lassen: Audio inklusive digitalem Output läuft, Netzwerk läuft, alle externen Ports laufen. Nächste CD rein und Treiber für die Grafikkarte installieren: meine beiden Monitore - mit unterschiedlicher Display-Ratio (was bislang - leider - noch jeden meiner Versuche mit einer Linux-Installation scheitern ließ) werden anstandslos erkannt und lassen sich einstellen. Das ist für jemanden, der vor knapp fünfzehn Jahren seinen ersten privaten Internet-Zugang erst nach tagelanger Schweißarbeit zustande bekommen hat schon bemerkenswert.

Eine der erwähnten Überraschungen war, als sich herausstellte, daß ich meinen Bedarf an PCI-Slots unterschätzt habe: neben der Audiokarte (nicht so ein Gedöns wie das eingebaute Audio, sondern 24Bit/96kHz und - vor allem - mit akzeptablen Werten, was die Latenz angeht) muß noch eine Karte für (digitales) Fersehen Platz finden. Letzteres hatte ich glatt vergessen - jetzt muß ich entweder das Audio-System, oder das Fernsehen durch ein externes Gerät ersetzen.

Apropos Gerät: in der Lieferung fehlte, wie unten schon erwähnt, das DVD-Laufwerk. Ich habe kurz entschlossen bei einem lokalen Händler ein Blue-Ray-Laufwerk gekauft - erstens: wenn schon alles auf dem letzten Stand ist, warum nicht auch das Laufwerk, zum zweiten werden einem die Dinger mittlerweile für knapp 100 Euro hinterher geschmissen. Was zur nächsten Überraschung führte: meine Surround-Installation ist nicht dazu zu bewegen, Blue-Ray-Audio jenseits von Stereo abzuspielen. Es war mir schon klar, daß "Dolby TrueHD", das native Format für Blue-Ray, von meinem Decoder nicht unterstützt wird. Bislang war ich aber davon ausgegangen, daß DTS obligatorisch als alternative Soundspur im Format vorgesehen ist - in der dem Laufwerk beiliegenden "Spiderman-III"-Disk ist das aber nicht der Fall. - Kein "Naja", sondern ein "Tja".

Glücklicherweise sind Blue-Ray-Disks eh noch viel zu teuer (obwohl die Grafikausgabe selbst auf meinem 1280x720 LCD-Fernseher verdammt gut aussieht).

Blue-Ray definiert für das eingebaute Dolby-TrueHD einen Downgrade-Pfad, um alte Audio-Hardware weiterhin lauffähig zu halten: die Spezifikation fordert eine Ausgabe von DTS bzw. Dolby-Digital 5.1, wenn das externe Gerät über den normalen digitalen Ausgang angesprochen wird (zwar keine offizielle Quelle, aber ich habe keine Lust, weiter zu suchen).

Wenn man PowerDVD verwendet, wird über SP/DIF jedoch ein PCM-Stereo-Signal ausgegeben. Den Grund hätte ich mir selber zusammenreimen können - ich hatte diesen ganzen Kopierschutz-Wahnsinn, der mich definitiv von Windows-Vista abhält, aber schon fast vergessen bzw. verdrängt. - Blue-Ray ist demnach bis auf weiteres keine Option, mit der ich etwas anfangen könnte (ich kaufe doch keine neue Hardware, bloß damit Kopierschutz funktioniert - AACS ist der BlueRay-Nachfolger des längst gecracktem CSS für DVDs).

Aus den FAQ bei CyberLink:

When I play Blu-ray Discs, the audio was set to SPDIF output, but my receiver only outputs stereo audio.

Issue:

PowerDVD send LPCM 2ch audio to AV receiver via SPDIF.

Cause:

PowerDVD down-samples HD audio from Blu-ray Discs to 48 KHz / 16-bit. This is because the un-protected digital audio cannot output due to the AACS requirements. A Windows PC lacks an internal secure audio path, that’s why your receiver does not receive the original audio bit stream. CyberLink is working with audio chip vendors to enable the proprietary interface for encryption of audio bus.

Focusrite Saffire LE

Der kleine Kasten rechts auf dem Foto ist ein Focusrite Saffire LE - ein FireWire-Audio- und MIDI-Interface mit 4 Inputs, 6 Outputs, und nochmals SP/DIF rein wie raus. Ich möchte keine Details auflisten (einen lesenswerten Testbericht des Geräts gibt es bei homerecording.de), finde es aber doch bemerkenswert, daß man für knapp dreihundert Euro heute von einem renommierten Hersteller von Pro-Audio-Equipment derart mit Features eingedeckt wird. Zudem war die Installation völlig problemlos (ich kann mich immer noch nicht so recht daran gewöhnen) - auch Cubase macht keine Zicken, sondern adressiert umgehend sämtliche Ausgänge im Mixer.

Das interessanteste Feature, das sich realisieren läßt, ist die Verwendung von Surround für die eigene Musik. Die sechs Outputs entsprechen genau einem 5.1-Speaker-Setup - ich habe das Saffire mit zwei Stereoeingängen meines Mischpults für Front- und Rear-Speaker verbunden, und dann noch mit zwei Monokanälen für Centerspeaker und Subwoofer. Das läßt sich dann genauso mischen, wie der Output meines Surround-Decoders: die beiden Rear-Kanäle gehen auf die Stereoanlage in meinem Rücken, der Rest (inklusive Subwoofer) auf die Studiomonitore auf dem Schreibtisch vor mir.

In Cubase gibt es ja eingebaute Panner, mit denen sich ein Signal auf beliebige Ausgänge verteilen läßt - u.a. auch auf 5.1-Surround. Zuerst flog also einiges an Percussion durch den Raum (man kann die Bewegungen des Panners auch aufnehmen bzw. automatisieren) - und als nächstes werde ich mal an einem Piano basteln, dessen Klang zwar brav von vorne kommt, das aber in einen Surround-Hall gebettet ist.

Ich habe heute einen Tip von einem Kollegen bekommen, der (u.a.) für den Optimierungs-Wahnsinn in der Audio-Engine von Cubase zuständig ist (und der mir auch empfohlen hatte, keine halben Sachen zu machen, sondern meinem neuen Rechner gleich eine Intel-i7 einzupflanzen): Hyperthreading sollte man ausschalten, weil die derzeitige Multi-Core-Implementierung der Audio-Engine davon ausgeht, daß echtes Multi-Processing möglich ist (das leuchtet mir durchaus ein: sonst bräuchte man kein Redesign des Codes, sondern könnte auf das zurückgreifen, was unter der Rubrik "Multi-Threading" eh schon implementiert ist).

Nachdem ich diesen Ratschlag beherzigt und im BIOS die acht (virtuellen) auf die vier (physikalisch existierenden) Kerne reduziert hatte, konnte ich die Latenz auf respektable 6ms herunter setzen (und ich bin wahrscheinlich noch nicht am Ende der Möglichkeiten) - wohlbemerkt, mit einem preiswerten Audio-Interface, und nicht mit einer Pro-Karte von Digidesign, RME o.ä. Der Task-Manager meldet (allerdings bei einem Projekt mit relativ wenigen VST-Instanzen) eine CPU-Usage von unter 15%.

Ribbón-Controller

Das merkwürdige Device auf dem Keyboard ist ein sog. Ribbon-Controller (der R2M von Doepfer): der lange Stab hat eine berührungsempfindliche Oberfläche, die sowohl auf den Punkt reagiert, an dem sie berührt wird, als auch auf die Intensität, mit der man drückt. Der Kasten darüber ist die Kontrolleinheit, mit der man festlegen kann, welche (MIDI-) Daten über solche Berührung gesendet werden.

Man kann damit zwei unterschiedliche Ebenen von Controller-Informationen mit nur einem Finger steuern. Ich habe das momentan so eingestellt, daß Aftertouch auf Druck, und „Expression” (Controller #11) abhängig von der Position ausgegeben wird - beide Parameter werden von den meisten Sample-Libraries unterstützt, wobei dann Aftertouch für die Filter und Controller #11 für Modulation zuständig ist. Damit läßt sich gerade länger liegenden Klängen (Streicher, Bläser, aber auch Pad-Sounds aus dem Synthi) eine gewisse Lebendigkeit verleihen - selbst, wenn diese Sounds mit vielen asynchronen LFOs programmiert wurden, klingen sie schnell recht statisch, wenn man nicht „live” noch ein wenig an ihnen dreht.

Sicherlich kann man denselben Effekt erreichen, indem man Aftertouch so erzeugt, wie sich das gehört (nämlich durch Drücken auf die Keyboard-Tasten), und gleichzeitig am Modulationsrad dreht. Das hat aber den Nachteil, daß man den „Expression”-Anteil des Spiels über zwei Hände verteilt, wobei die rechte Hand auch noch für die Töne zuständig ist. Über den Ribbon-Controller gelingt dies wesentlich logischer - es fühlt sich ein wenig so an, als ob man mit dem Bogen auf einer Geige den Ton gestaltet. - Zum zweiten verfügen viele Keyboards mit gewichteten Tasten gar nicht erst über Aftertouch - so auch meines.

Das R2M[1] ist solide verarbeitet (Metall, kein Plastik), und funktioniert problemlos und reagiert präzise. Dafür ist es zwar relativ teuer - ich kenne allerdings auch keine Alternative (gelegentlich findet man die Idee auch auf einer Remote-Control verwirklicht - aber nicht in Gestalt einer 50cm langen Oberfläche).

- [1] Die Doepfer-Seiten sind Frame-Hölle, deshalb fehlt der Site nach dem Link die Navigation.

- Impressum

- Hosted by Manitu

- PHP-Credits

- Lizenz (CC)